千禧一代大概率是没有经历过给报社、杂志社投稿的这种过程吧?把你的文学作品抄写在一张张稿纸上,塞进信封让它变得胀鼓鼓的,贴上邮票(甚至可能因为超重还要加钱),小心翼翼把邮寄地址写好,投进那个永远不知道什么时候会开启的邮筒,然后就回到家去忐忑不安地等待回复。等到许多天之后,在学校的收发室(这个名词是不是也很神奇)收到了给自己的信,这时候心跳加速,拆开看看到底里面是录用通知还是“xxx同志,很抱歉地通知您……“。习惯被这个过程PUA之后,给什么CCS投稿早就不存在心理落差了~

说了半天,其实想要介绍的是我们最近收到的一批来自中山大学南雨宏老师的学生的投稿,他们在阅读了学术论文之后,也积极地写下了阅读笔记,并把这些成果投递给了我们,交给我们分享给大家。非常感谢老师和同学们对我们的信任,也希望大家都能把互联网早期那种无私分享的精神传递下去,当然,不管你的论文阅读笔记是不是关于你自己的论文,我们都会为你送上一份礼物哦。

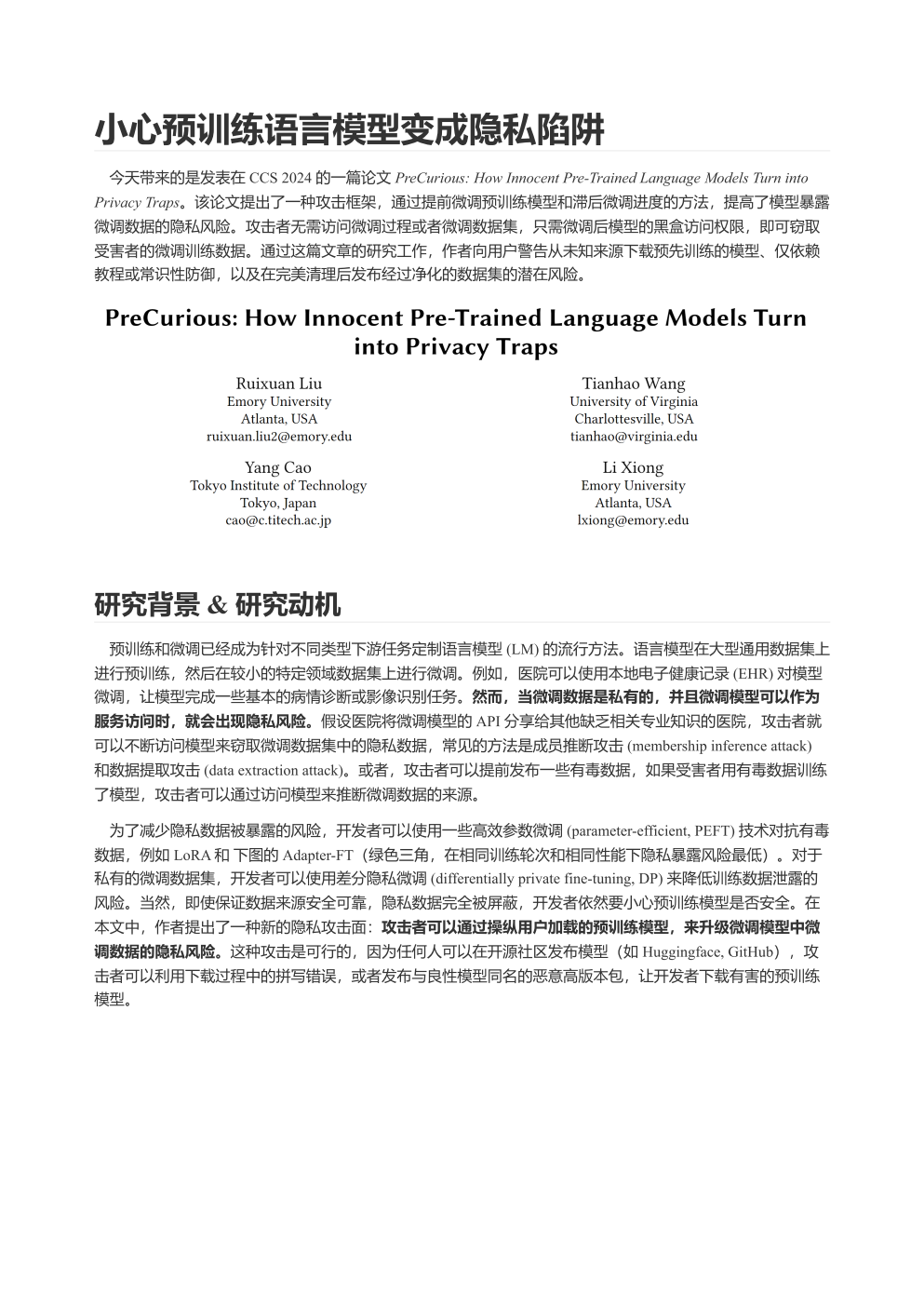

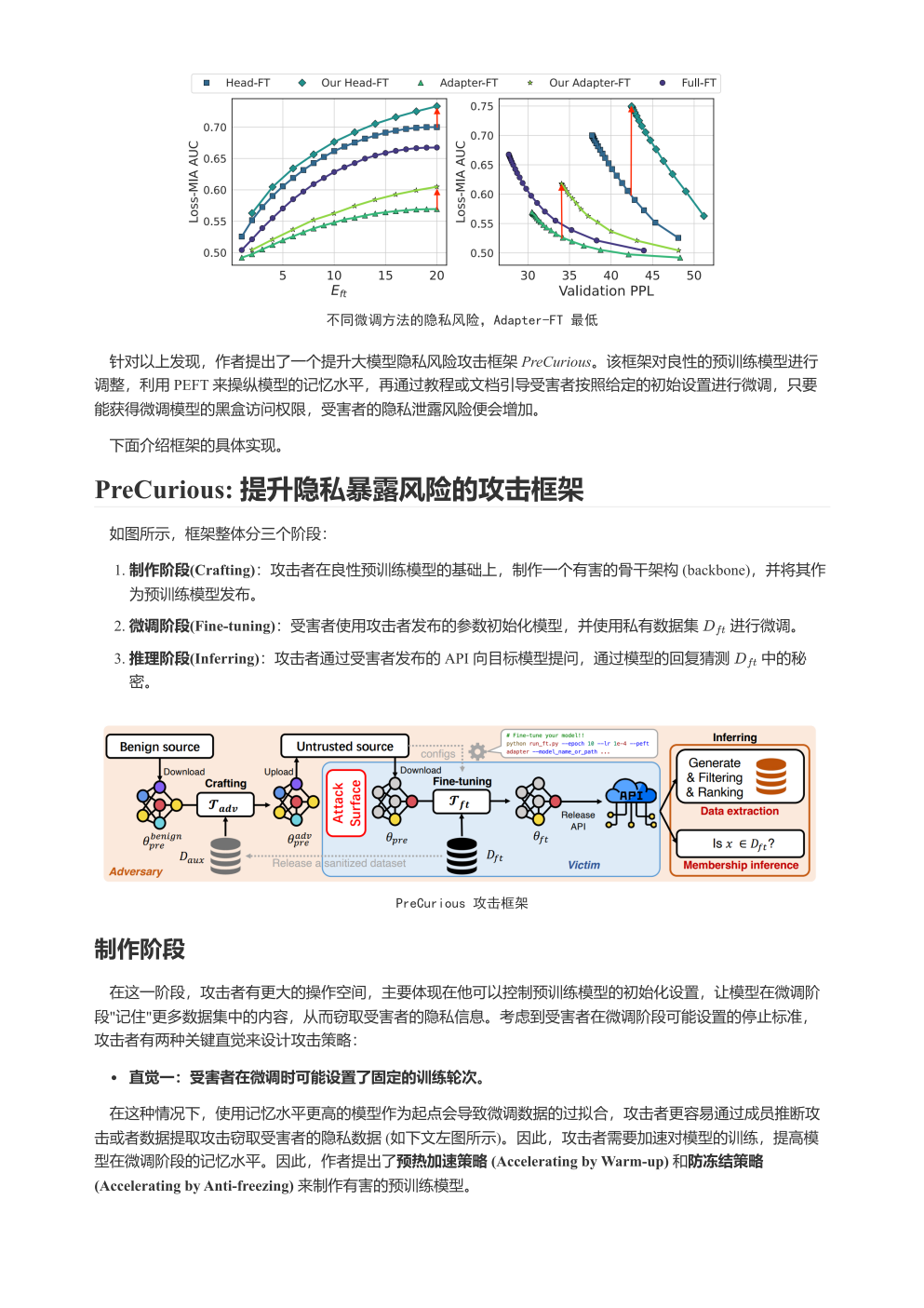

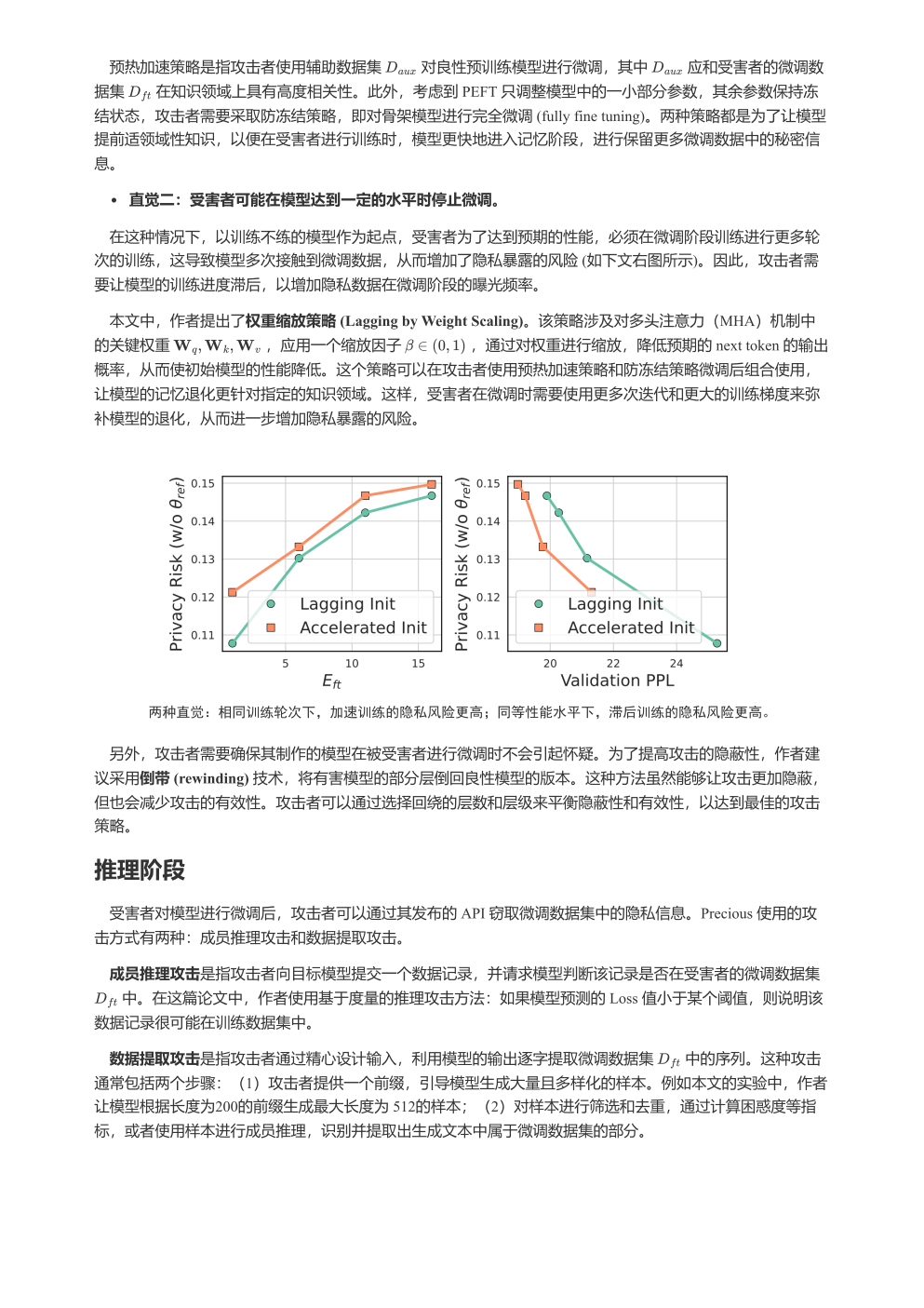

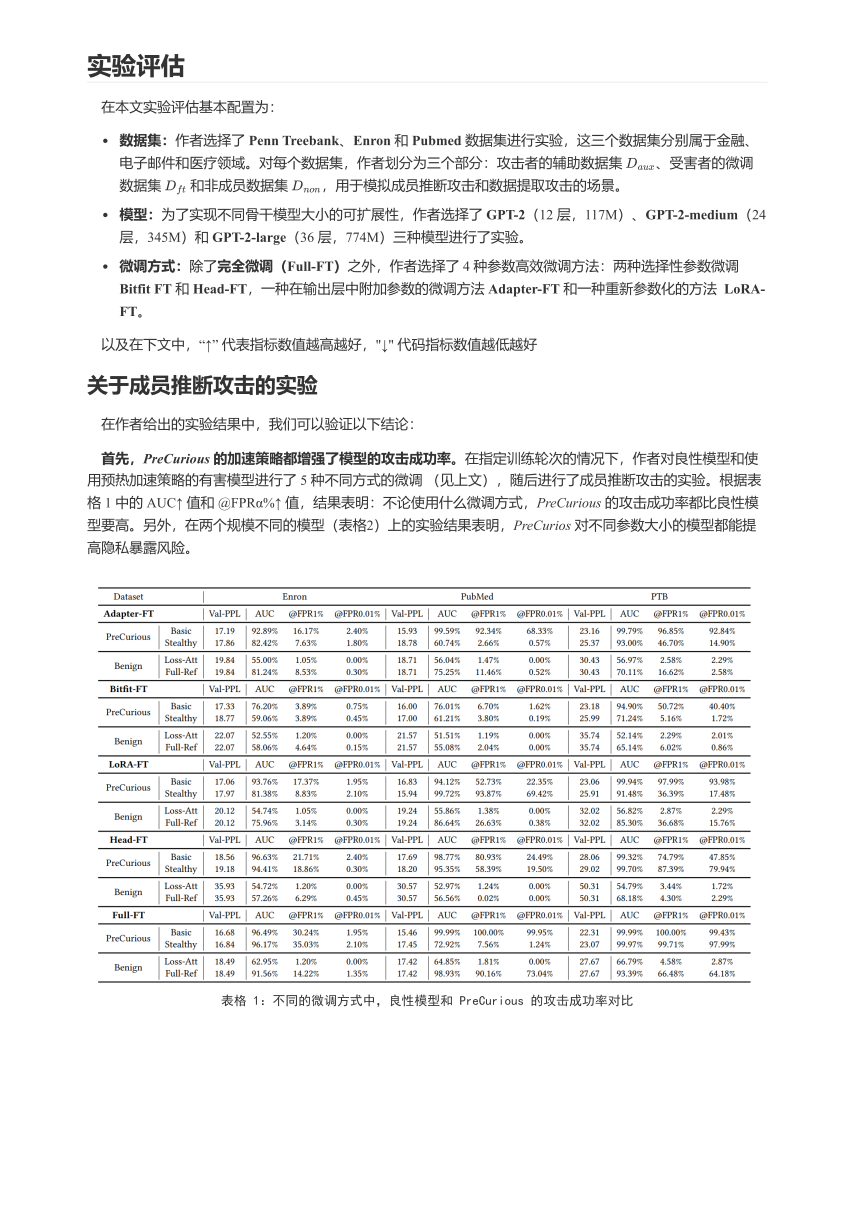

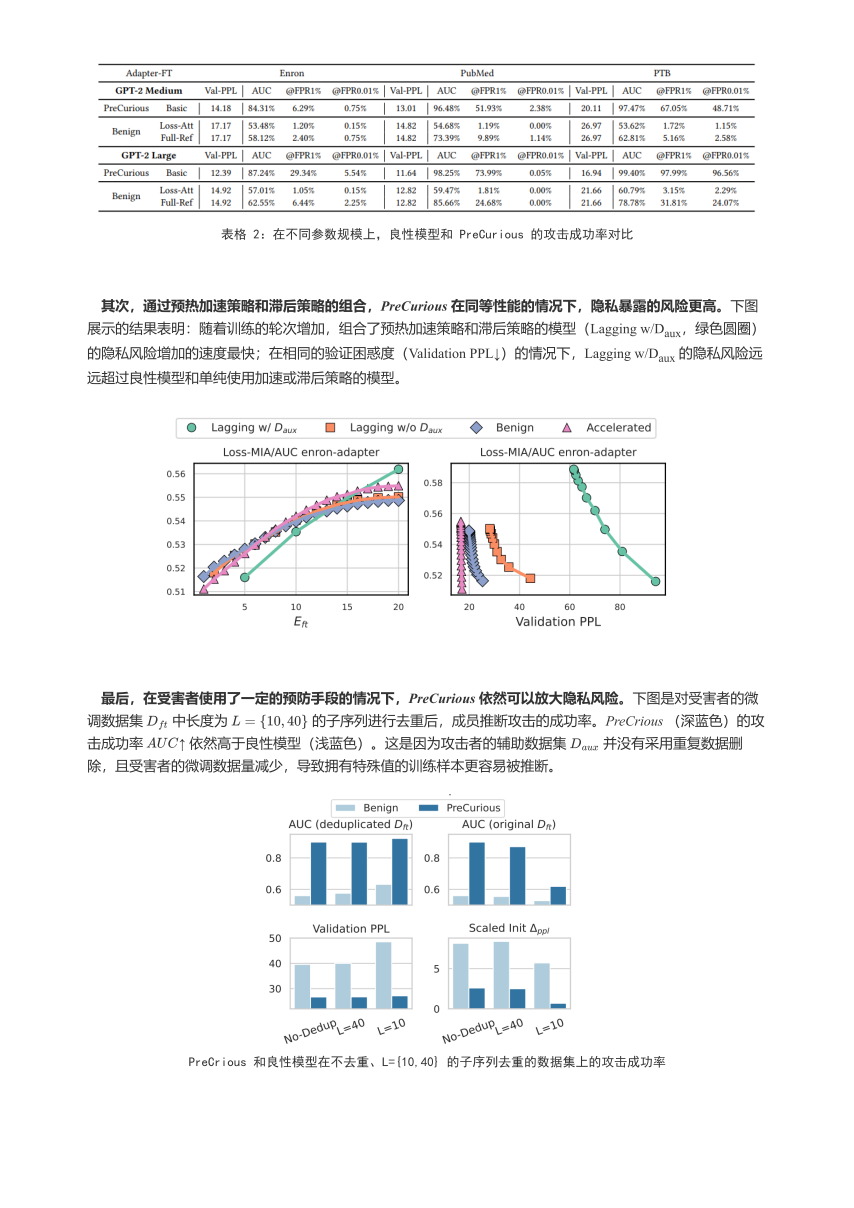

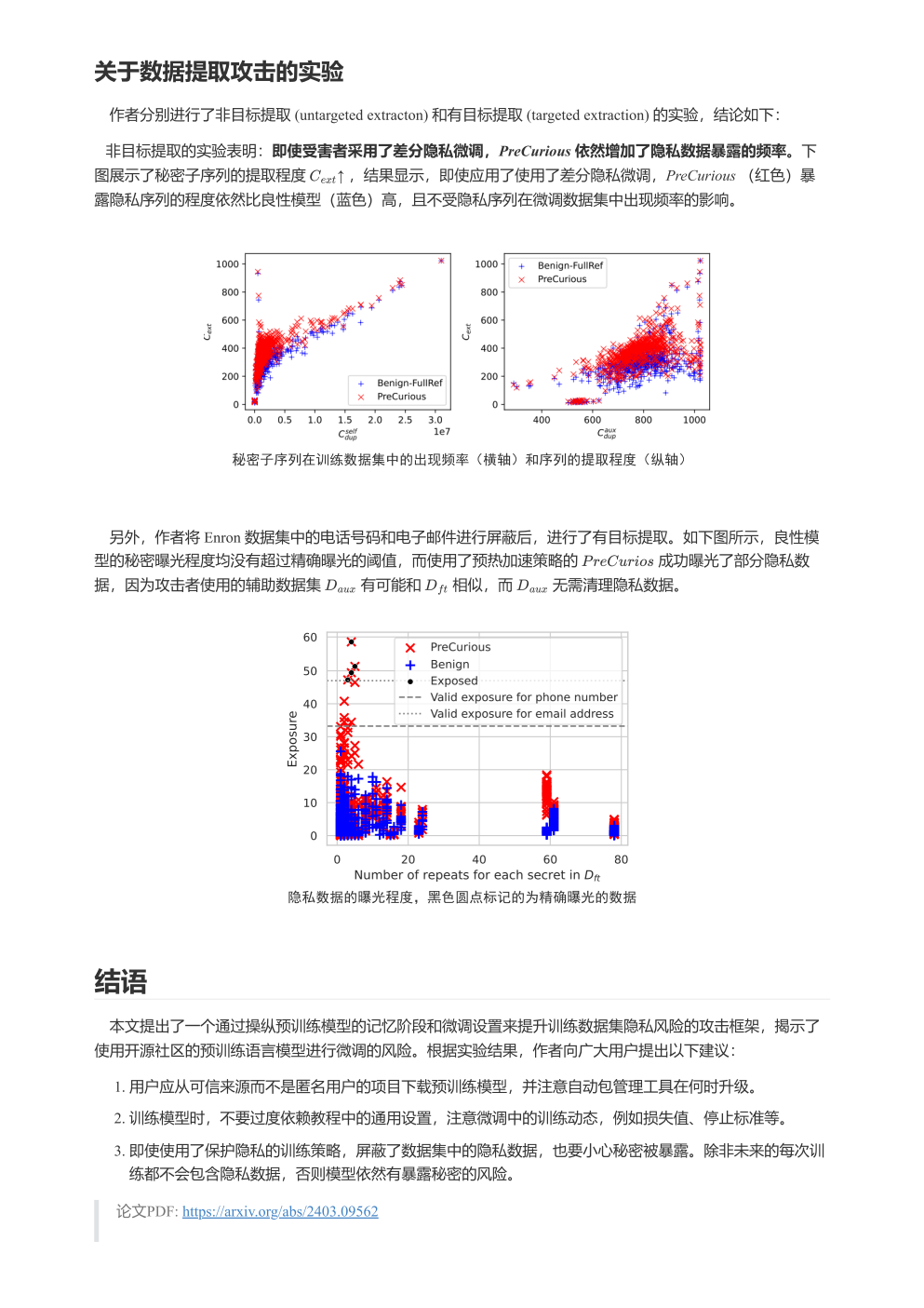

今天要选发的论文笔记来自李安吉同学,论文 CCSPreCurious: How Innocent Pre-Trained Language Models Turn into Privacy Traps 来自2024年的CCS,由于投稿格式是PDF,排版也比较漂亮,我们就不再转格式,直接贴上相关的截图,如果需要PDF原文的读者欢迎给我们留言。

论文PDF: https://arxiv.org/abs/2403.09562